محاسبات لبه در IOT

راهحلهای مبتنی بر محاسبات مه (Fog Computing) توسط بسیاری از صنایع در حال پذیرش است و تلاشها برای توسعهی برنامههای کاربردی توزیعشده و ابزارهای تحلیل با سرعتی فزاینده در حال معرفی است. جایگاه طبیعی یک گرهی مه در دستگاه شبکهای است که نزدیکترین جایگاه را به نقاط پایانی اینترنت اشیاء دارد و این گرهها به طور معمول در سراسر شبکهی اینترنت اشیاء پراکندهاند. با این حال، در سالهای اخیر، مفهوم محاسبات اینترنت اشیاء حتی بیشتر به سمت لبه سوق داده شده است و در برخی موارد اکنون به طور مستقیم در حسگرها و دستگاههای اینترنت اشیاء قرار دارد.

با این حال، دستگاهها و حسگرهای اینترنت اشیاء اغلب منابع محدودی دارند، هرچند که قابلیتهای محاسباتی در حال افزایش است. برخی از کلاسهای جدید نقاط پایانی اینترنت اشیاء به اندازهی کافی قابلیت محاسباتی دارند تا حداقل بتوانند تحلیل و فیلتر کردن در سطح پایین را برای اتخاذ تصمیمات اساسی انجام دهند. به عنوان مثال، سنسور آب را روی یک شیر آتشنشانی در نظر بگیرید. در حالی که یک گرهی مه که روی یک تیر برق در شبکهی توزیع قرار دارد، ممکن است نمای عالی از تمام شیرهای آتشنشانی در یک محلهی محلی داشته باشد، یک گره روی هر شیر آتشنشانی نمای واضحی از افت فشار آب در خط خودش خواهد داشت و قادر خواهد بود به سرعت یک هشدار در مورد یک مشکل موضعی ایجاد کند. از طرف دیگر، گرهی مه نمای گستردهتری خواهد داشت و قادر خواهد بود تشخیص دهد که آیا مشکل فقط موضعی است یا کل منطقه را تحت تأثیر قرار داده است. مثال دیگر در استفاده از کنتورهای هوشمند است. کنتورهای دارای قابلیت محاسبات لبهای قادرند با یکدیگر برای به اشتراک گذاشتن اطلاعات در زیرمجموعههای کوچکی از شبکهی توزیع برق برای نظارت بر کیفیت و مصرف برق محلی ارتباط برقرار کنند و میتوانند یک گرهی مه را از رویدادهایی که ممکن است فقط مربوط به بخشهای بسیار کوچکی از شبکه باشد، مطلع سازند. چنین مدلهایی به اطمینان از بالاترین کیفیت تحویل برق به مشتریان کمک میکنند.

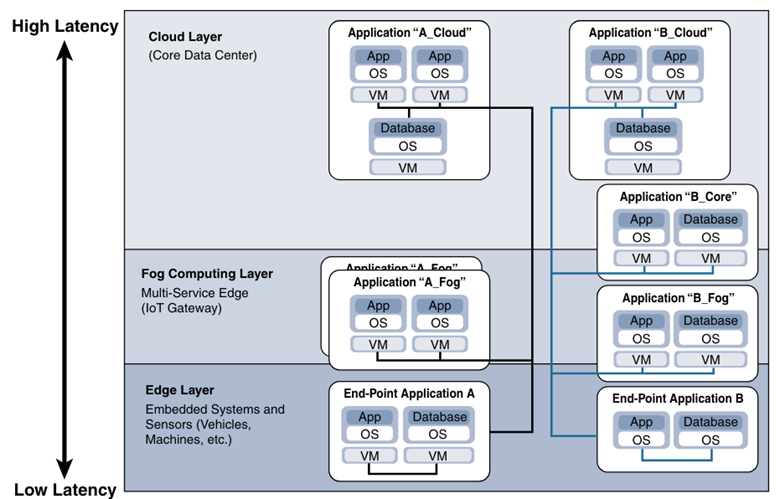

در حالی که انتظار میرود منابع ابری همگن باشند، انتظار میرود که در بسیاری از موارد، منابع لبه و مه از سیستم عاملهای مختلف، قابلیتهای CPU و ذخیرهسازی دادههای مختلف و مشخصات مصرف انرژی متفاوتی استفاده کنند. بنابراین لبه و مه به لایهی انتزاعی نیاز دارند که به برنامههای کاربردی اجازه دهد تا با یکدیگر ارتباط برقرار کنند. لایهی انتزاعی مجموعهی مشترکی از رابطهای برنامهنویسی کاربردی (API) را برای نظارت، تهیه و کنترل منابع فیزیکی به روشی استاندارد در معرض دید قرار میدهد. لایهی انتزاعی همچنین نیازمند مکانیزمی برای پشتیبانی از مجازیسازی است، با قابلیت اجرای چندین سیستم عامل یا مخزنهای سرویس روی دستگاههای فیزیکی برای پشتیبانی از چند استفاده کننده و ثبات برنامهی کاربردی در سراسر سیستم اینترنت اشیاء. تعریف یک چارچوب خدمات ارتباطی مشترک توسط گروههایی مانند oneM2M، که قبلاً مورد بحث قرار گرفت، در حال انجام است. شکل زیر ماهیت سلسلهمراتبی محاسبات لبهای، مه و ابری را در سراسر یک سیستم اینترنت اشیاء نشان میدهد.

از دیدگاه معماری، گرههای مه نزدیک به لبهی شبکه، دادهها را از دستگاههای اینترنت اشیاء دریافت میکنند. سپس، برنامهی کاربردی اینترنت اشیاء مه، انواع مختلف داده را به مکان بهینهی تحلیل هدایت میکند:

حساسترین دادهها از نظر زمان در لبه یا نزدیکترین گرهی مه به اشیایی که داده را تولید میکنند، تجزیه و تحلیل میشود.

دادههایی که میتوانند برای اقدام، چند ثانیه یا چند دقیقه صبر کنند، برای تجزیه و تحلیل و اقدام به یک گرهی تجمعی منتقل میشوند.

دادههای کماهمیتتر از نظر زمان برای تحلیل تاریخی، تحلیل کلانداده و ذخیرهسازی بلندمدت به ابر ارسال میشوند. به عنوان مثال، هر یک از هزاران یا صدها هزار گرهی مه ممکن است خلاصههای دورهای از دادهها را برای تحلیل و ذخیرهسازی تاریخی به ابر ارسال کنند.